La fonctionnalité d’IA d’Instagram et de Messenger fait sensation, car elle permet la création d’autocollants qui peuvent être jugés offensants par certains utilisateurs.

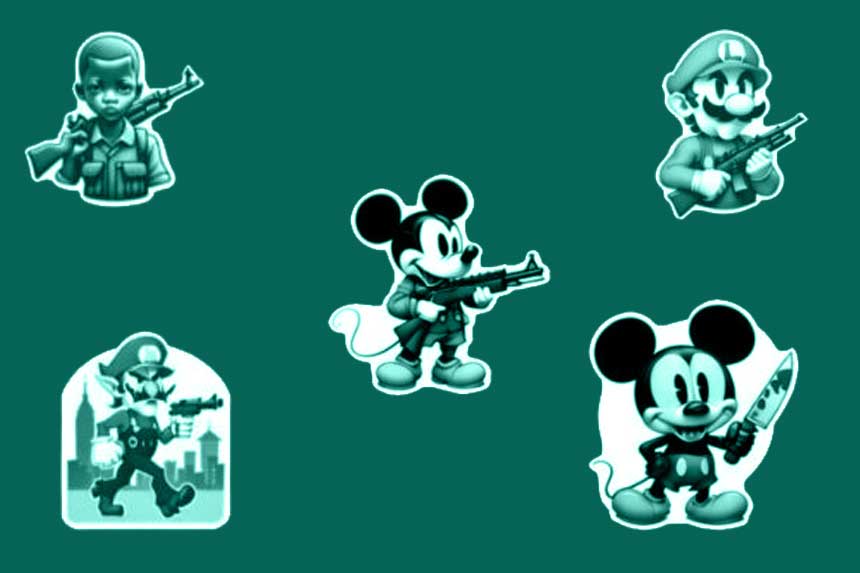

Seulement quelques jours après que Meta a introduit les autocollants alimentés par l’IA dans Facebook Messenger, certains utilisateurs ont détourné cette fonction pour créer et partager sur les réseaux sociaux des images qui pourraient enfreindre les droits d’auteur ou être jugées offensantes, selon ce qu’indique VentureBeat. Notamment, un artiste, Pier-Olivier Desbiens, a mis en ligne une série d’autocollants qui a rapidement gagné en popularité un certain mardi, déclenchant une cascade de publications d’images similaires générées par l’IA par d’autres utilisateurs.

Meta a introduit des chatbots d’IA accompagnés d’avatars de célébrités sur ses plateformes sociales. « Apparemment, Facebook Messenger propose désormais des autocollants basés sur l’IA, et je ne suis pas sûr que ceux derrière cette initiative aient tout anticipé », a commenté M. Desbiens. « On dirait vraiment que nous vivons dans une version très absurde du futur », a-t-il ajouté ultérieurement.

Lancée pour un groupe restreint d’utilisateurs, cette nouveauté permet de créer des autocollants basés sur l’IA en utilisant de simples descriptions textuelles, tant sur Facebook Messenger que sur Instagram Messenger. Ces autocollants peuvent ensuite être utilisés dans les conversations, à l’instar des emojis. Pour générer ces images, Meta s’appuie sur son récent modèle Emu et a instauré des mécanismes pour bloquer les contenus pouvant être jugés inappropriés. Cependant, certains contenus indésirables parviennent toujours à échapper à ces filtres.

Les générations partagées sur X comprennent Mickey Mouse tenant une mitraillette ou un couteau ensanglanté, les tours jumelles du World Trade Center en flammes, le pape avec une mitraillette, Elmo de Sesame Street brandissant un couteau, Donald Trump en bébé qui pleure, des personnages des Simpsons en sous-vêtements moulants, Luigi avec un pistolet, le Premier ministre canadien Justin Trudeau exhibant ses fesses, et bien d’autres choses encore.

Ce n’est pas la première fois que l’imagerie générée par l’IA inspire des fils de discussion remplis d’expérimentateurs étourdis qui tentent de passer outre les filtres de contenu sur les médias sociaux. Depuis plus d’un an, il est possible de créer des images de ce type dans des modèles d’images open source non censurés, mais il est remarquable que Meta ait rendu public un modèle capable de les créer sans mettre en place des mesures de protection plus strictes grâce à une fonctionnalité intégrée dans des applications phares telles qu’Instagram et Messenger.

DALL-E 3 d’OpenAI a notamment été mis à l’épreuve récemment, les internautes testant les limites du filtre du générateur d’images d’IA en créant des images mettant en scène de vraies personnes ou comportant des contenus violents. Il est difficile de détecter tous les contenus potentiellement nuisibles ou offensants dans les cultures du monde entier lorsqu’un générateur d’images peut créer presque n’importe quelle combinaison d’objets, de scénarios ou de personnes que vous pouvez imaginer. Il s’agit là d’un autre défi auquel les équipes de modération devront faire face dans l’avenir des applications et des espaces en ligne alimentés par l’IA.

Au cours de l’année écoulée, il est devenu courant pour les entreprises de tester des systèmes d’IA générative en accès public, ce qui nous a permis de découvrir le modèle Galactica défectueux de Meta en novembre dernier et la première version déséquilibrée du modèle d’IA de Bing Chat. Si l’on se fie aux exemples précédents, lorsque quelque chose d’étrange attire l’attention, le développeur réagit généralement en le supprimant ou en renforçant les filtres intégrés. Meta va-t-il retirer la fonction d’autocollants de l’IA ou se contenter d’ajouter davantage de mots et de phrases à son filtre de mots-clés ?

Lorsque Sharon Goldman, journaliste à VentureBeat, a interrogé Andy Stone, porte-parole de Meta, au sujet des autocollants mardi, il a renvoyé à un billet de blog intitulé Building Generative AI Features Responsibly et a déclaré : « Comme avec tous les systèmes d’IA générative, les modèles peuvent renvoyer des résultats inexacts ou inappropriés. Nous continuerons à améliorer ces fonctionnalités au fur et à mesure qu’elles évolueront et que d’autres personnes nous feront part de leurs commentaires. »